自然语言处理 Natural Language Processing (NLP)

常见的工具:拼写检查器、自动完成、机器翻译、语音识别和语音合成系统、网络搜索

其他应用:情感分析、趋势预测、数字取证、仇恨言论监控、假新闻检测、推荐系统。

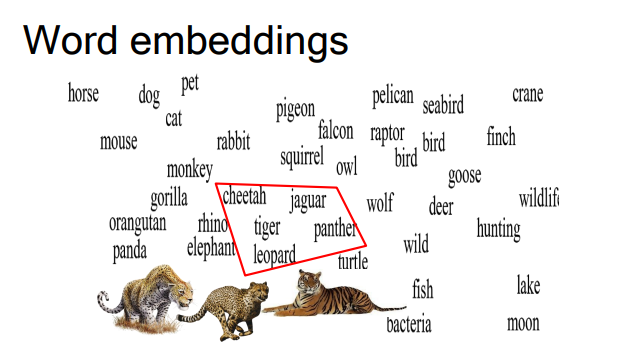

词嵌入 Word embeddings

词嵌入是表示单词在空间中为点的向量空间。

相似的单词在向量空间中表示得很接近。

对于许多自然语言处理(NLP)应用来说很有用。

定义

词嵌入是自然语言处理(NLP)中的一种技术,它将文本中的单词或短语映射到实数向量。这些向量通常是由训练过程中学习而来的,并且位于高维空间中。每一个维度都可能捕捉到语言的某些方面,比如语法、语义等。

工作原理

- 向量空间模型:词嵌入基于向量空间模型,这是一个假设将单词表示为向量可以使得语义上相似的单词在空间中的距离更近的概念。

- 上下文关联:词嵌入通常通过考虑单词的上下文来捕获其语义,这是基于分布假说的理论,即在相似上下文中出现的单词意义上相似。

- 维度与特征:每个维度代表了单词的一个潜在特征,但这些特征不一定是直接解释的。维度的数量可以调节,更多的维度可以捕获更细致的语言特性,但同时也增加了计算复杂性。

训练

- 神经网络:词嵌入通常通过训练神经网络模型获得,如

Word2Vec、GloVe等。 - 无监督学习:词嵌入模型通常使用大量无标记文本数据进行训练,这是一种无监督学习。

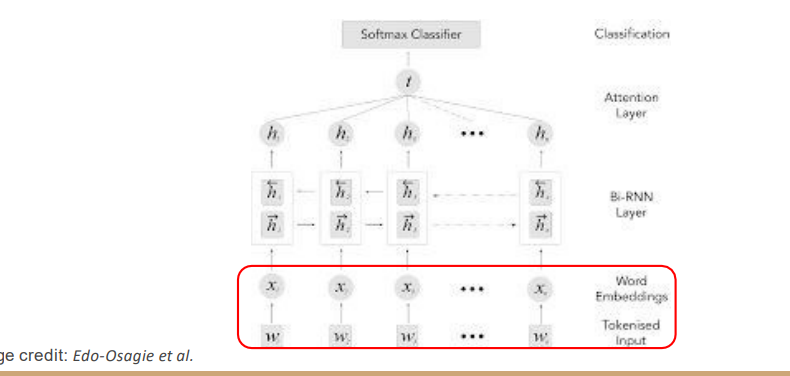

词嵌入作为神经网络输入

词嵌入经常被用作神经网络架构中的输入。在许多框架中(例如Keras),这个初始层被称为嵌入层(embedding layer)。通过使用嵌入,神经网络获得了泛化和背景知识的能力。

在神经网络中,词嵌入层通常作为网络的第一层,将单词转换为一组向量。这些向量捕获了单词的语义特征,并能够表示单词之间的相似性。通过将这些嵌入向量作为输入,神经网络可以更有效地进行学习,理解和处理自然语言数据。

例如,在一个文本分类任务中,网络会首先接收到一系列单词的嵌入表示,然后通过进一步的层(如循环神经网络层、注意力层等)来处理这些数据,最终通过一个或多个全连接层(例如Softmax分类器)来进行分类。

这种架构使得网络不仅能够处理单个单词,而且能够理解上下文和词序,这是处理自然语言的关键。

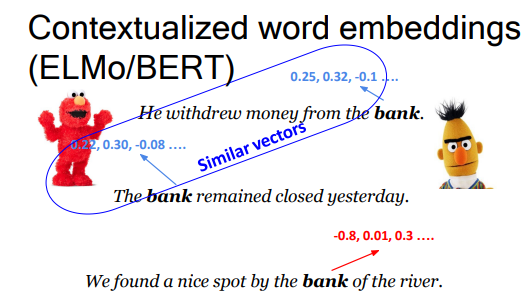

上下文化词嵌入(ELMo/BERT)

- 通过利用在大量文本语料库上的语言模型学习词嵌入。

- 新特点:每个词向量依赖于上下文。它是动态的。

- 在许多自然语言处理(NLP)任务中都有重要的改进。

传统的词嵌入模型,如Word2Vec或GloVe,为每个单词生成一个固定的向量表示,这意味着无论单词出现在什么上下文中,其表示都是一样的。然而,上下文化词嵌入模型(如ELMo和BERT)对此进行了改进,它们为单词在不同上下文中生成不同的向量表示。

例如,在下面的句子中,"bank"这个词会根据不同的上下文有不同的向量表示:

- "He withdrew money from the bank."(他从银行取了钱。)

- "The bank remained closed yesterday."(银行昨天一直关闭。)

- "We found a nice spot by the bank of the river."(我们在河岸边找到了一个好地方。)

在这些句子中,"bank"一次是指金融机构,另一次是指河堤。ELMo和BERT这样的模型能够根据上下文捕捉到这种区别,并为每个实例生成不同的向量。

这种技术在理解词义的多样性和复杂性方面非常有用,它允许模型更准确地理解和处理语言。

论点鲜明,论据链环环相扣,论证有力。

这是一篇佳作,无论是从内容、语言还是结构上,都堪称完美。

这篇文章不错!